정보량

정보란? =상태에 대한 지식= 의미 있는 데이터

=>정보 표현에 필요한 "최소한의 비트 수"

=>정보가 데이터중 얼마인지,

단위:bit (양자 택일시 0/1) = 1bit =log(2)2

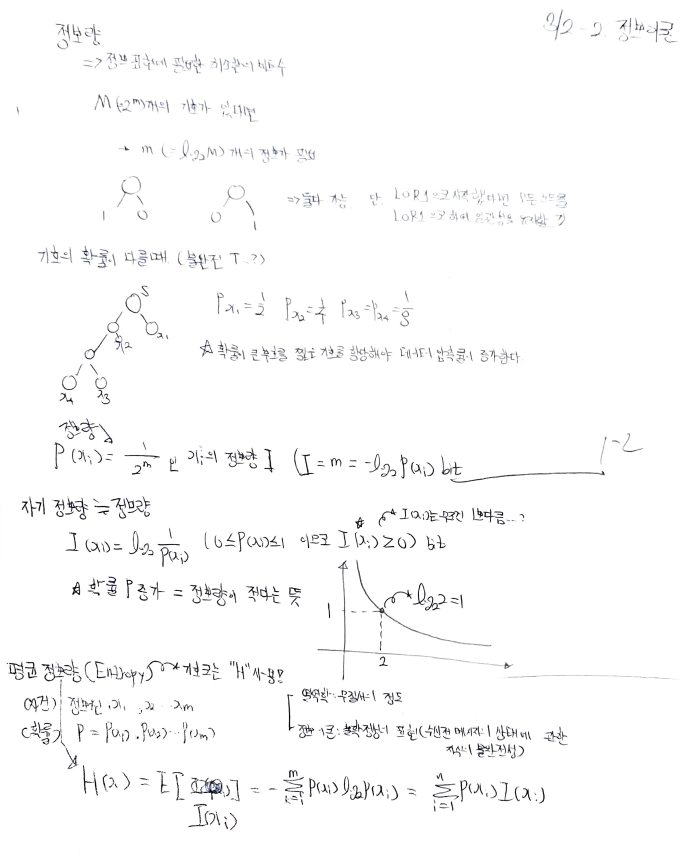

즉, M(2^m) 개의 기호가 있다면, m(= log2M)개의 정보가 필요하다는 이야기.

**LOR로 시작했다면, 끝까지 LOR 로 해야함, 중간에 ROL로 변경할 경우 문제 발생!

**확률이 큰 기호에 짧은 부호를 할당해야 하는 이유

=>확률이 크다는건 그만큼 언급(불려오는) 횟수가 많다는 이야기 이기 때문에 레지스터의 크기가 가까울 수록 유리하겠죠?

H(X) = E[I(Xi)] = -(Sigma i to m)P(xi)log2P(Xi) = (Sigma ito m) P(Xi)I(Xi)

Ex. 문제 풀이, P(0) =0.8// P(1) = 0.2 라고 가정하고 문제를 품.

Hmax= 기호, 즉 상태가 2개이므로 log2^2 =1이라는 것을 알 수 있음. (log2M이 Hmax)이므로.

H(X)= 엔트로피는 위의 식, -Sigma..에 의해

-0.8(log2(0.8) -0.2(log2(0.2) => 전개 후 풀면 0.72가 나오게 됨.

h(정보원 x의 상태) = 0.72/1 == 0.72

r(Redundacy) , =1-0.72 ==0.28

(흐린 부분)

경기 사람의 충남 외출시, 경기의 일기 예보는 얼마나 신뢰 할 수 있는가?

X(H(x)) , Y(H(y))

=>H(x|y)의 상호정보량 I(X:Y) =(H(x) -H(x|y))==(H(y) -H(y|x))==H(x)+H(y)-H(x,y)

P(x|y)=P(x,y)/P(y)

=============================

기억이 없는 정보원=>정보원의 발생이 다른 시점과 독립이라는 것(랜덤 발생)

==>확률 편증이 없으며, 현실세계에는 이딴 건 없음.

마르코프 정보원(기억 있는 정보원)

=>마르코프 과정을 따름.

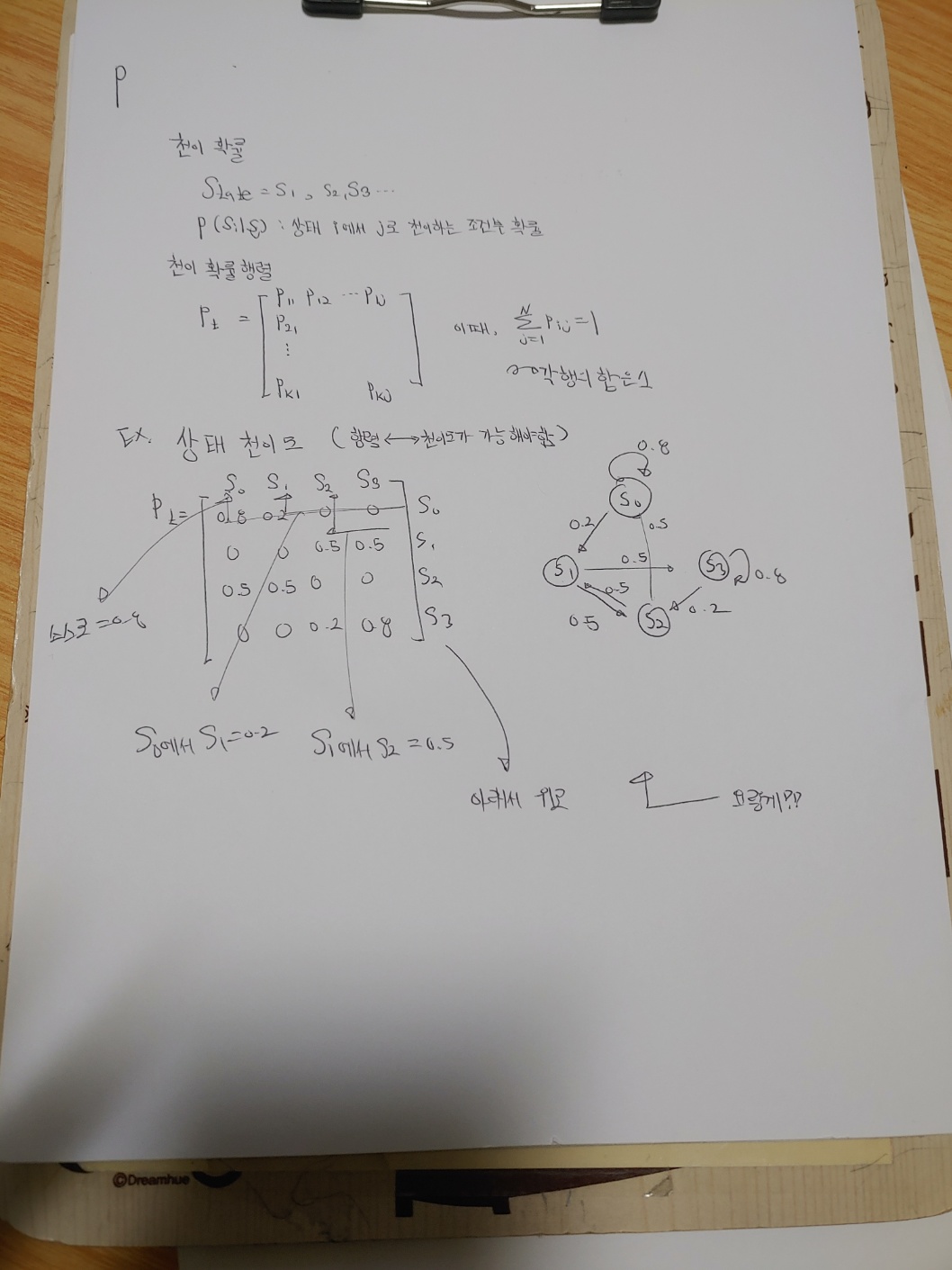

상태(State)

=>새로운 기호의 발생은 상태의 천이를 의미함

(상태에 의해 다음 기호의 출현 확률을 예측 할 수 있음.)

마르코프 과정

=>기호를 발생하며 상태에서 상태로 천이를 반복하는 과정.

P(xi|x1,x2,x3 ... xn-1) = P(Xi|Xi-m+1, Xi-m+2... Xi-1)

1차 마르코프 정보원

P(x1, x2, x3.. xn) = P(x1)P(X2|x1)P(X3|X2)P(X4|X3)...P(Xn|Xn-1)

Zero order Src=>독립 정보원, (기호 +상태)

상태 천이도 및 그림그리기(행렬보고) 알아 둘 것.

팁이라면 행렬의 우측 열 번호를 타고 올라간다고 생각하면 될듯?

(ㄴ자를 오른쪽에서부터 왼쪽으로 그린다는 느낌..?)

그림을 보고 행렬을 그릴 때에는

1)일단 자기 자신을 회귀하는거 먼저 채우고

2)S0 =>S1 (이동값 0.2)라면

S0 행의 S1열에 값을 기입하면 됨!!

ppt 3-1부분임! 필요하면 다시 볼 것.

(상호정보량, 엔트로피 부분 복습 요함)

'3-1학기 과목(지금 볼거X) > 정보이론' 카테고리의 다른 글

| 6주-1 (0) | 2023.04.06 |

|---|---|

| 5주차 정보이론 (0) | 2023.04.02 |

| 4주차 정보이론 (0) | 2023.03.26 |

| 3/7~10 정보 이론 1주차 (2) | 2023.03.15 |